-

Rešitve in storitve

RešitveZanesljiva hramba in varnost podatkov

Diskovni sistemi NetApp, Dell in FujitsuHitra in učinkovita obdelava podatkov

Platforma Splunk EnterpriseInformacijska varnost

Zaščita končnih točk, požarne pregrade, SIEMInfrastruktura v našem oblaku

Najem IT opremeAdministracija in optimizacija sistemov

Upravljanje in vzdrževanje - Podjetje

- Novice

- Kontakt

- Zaposlitev

Rešitve

Zanesljiva hramba in varnost podatkov

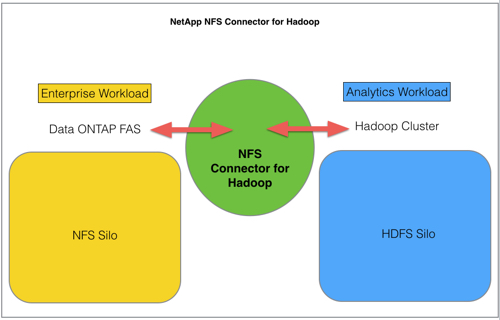

Diskovni sistemi NetApp, Dell in Fujitsu

Diskovni sistemi NetApp, Dell in Fujitsu

Hitra in učinkovita obdelava podatkov

Platforma Splunk Enterprise

Platforma Splunk Enterprise

Informacijska varnost

Zaščita končnih točk, požarne pregrade, SIEM

Zaščita končnih točk, požarne pregrade, SIEM

Infrastruktura v našem oblaku

Najem IT opreme

Najem IT opreme

Administracija in optimizacija sistemov

Upravljanje in vzdrževanje

Upravljanje in vzdrževanje

Storitve

Blog Čebelnjak